5.

OpenAI WebAPI

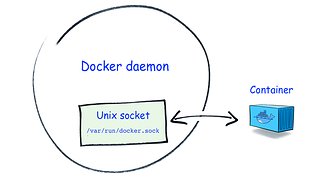

完成 CLI 的方式之後,要來測試 web api 的作法。目前提供的是相容於 OpenAI 的呼叫,而且可以作分散式,就是需要先把 Controller 跑起來,然後指定 Worker,如果有多個 Worker 的話,就為自動分配負載喔~

# 指定 local,不然會跑去 OpenAI

export OPENAI_API_KEY=YOUR_API_KEY

export OPENAI_API_BASE=http://localhost:8000/v1

# 執行 controller

python -m fastchat.serve.controller --host 0.0.0.0 --port 21001

# 執行 Worker

python -m fastchat.serve.model_worker \

--model-name 'gpt-3.5-turbo,text-davinci-003,text-embedding-ada-002,vicuna-13b' \

--model-path lmsys/vicuna-13b-v1.3 --host 0.0.0.0 --controller-address http://localhost:21001 --port 21002 --device cpu

# 執行 API Server

python -m fastchat.serve.openai_api_server --host 0.0.0.0 --port 8000 --controller-address http://localhost:21001

這樣只要連線 http://localhost:8000 就可以囉!